概要说明

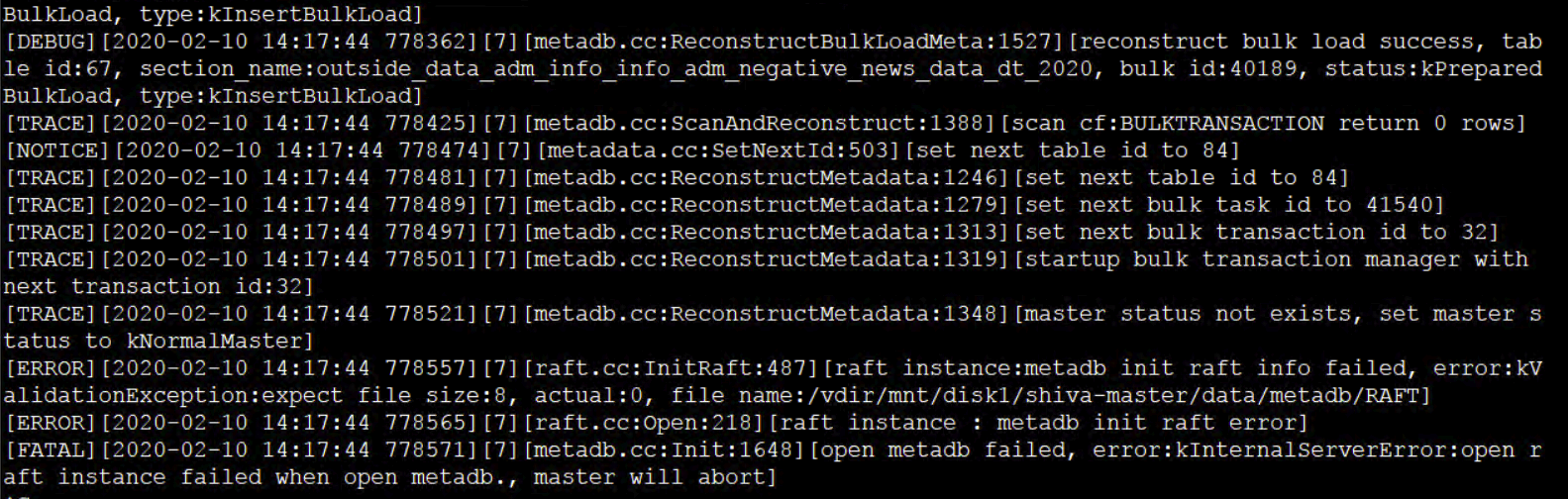

本案例用于解决集群内Shiva Master数量异常,如何在Shiva的web页面修复master group,例如Shiva Master的master.log中报错如下,可以使用此方法修复:

注意:修复的前置条件是至少有一台Shiva Master的状态是正常的!

详细说明

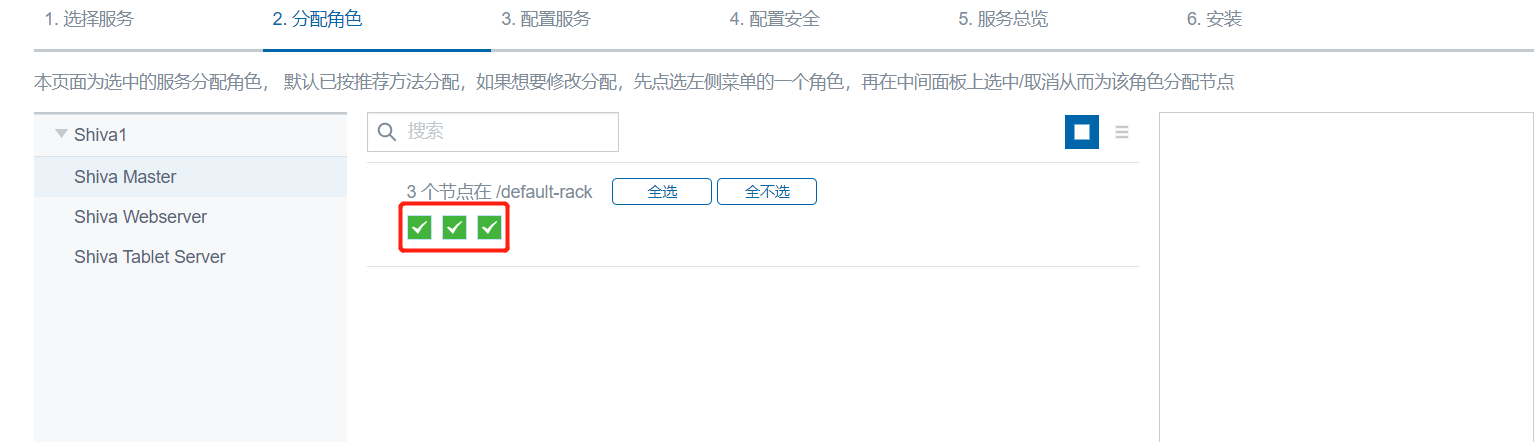

Shiva安装时默认推荐的Shiva Master节点数应该至少是3(此处集群内有三个节点,那么1,2,3节点都必须安装),当Master group只剩少数节点存活时,Master无法提供服务,为了保证Master之间的数据一致,修复逻辑是首先选择一台存活的Master,通过 set_master_group 让其成为一个只有自己的一个成员的Master Group,之后再向该group加入新的master节点,直到master group有足够的节点,一般为3或5。

操作步骤

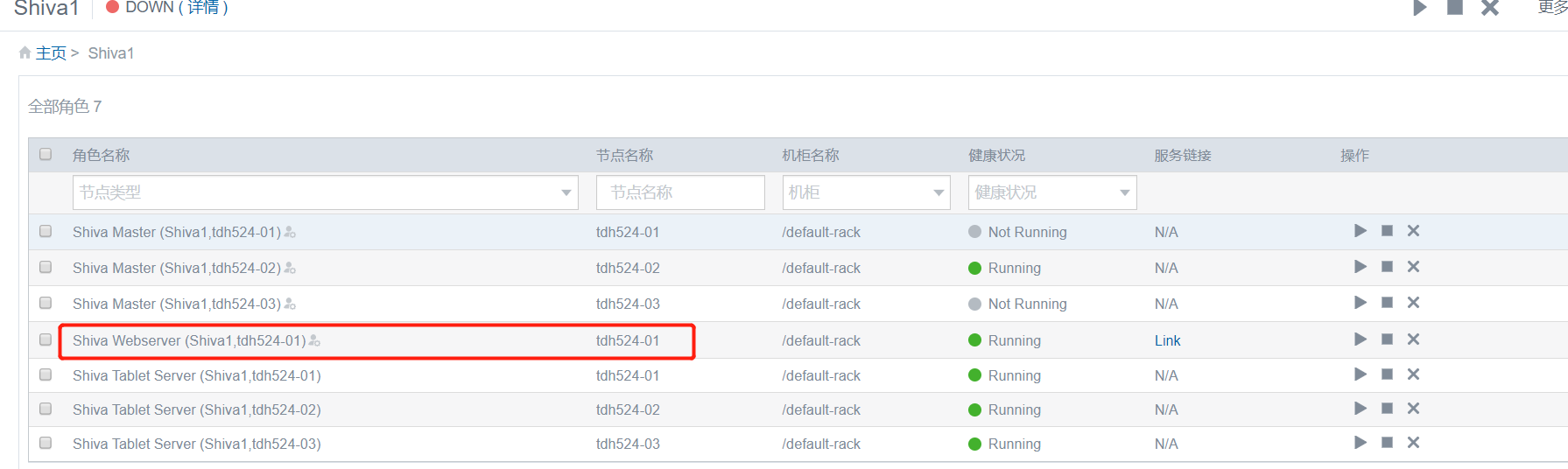

1、检查Shiva webserver所在主机IP:

此处节点为tdh524-01,IP为172.22.17.1

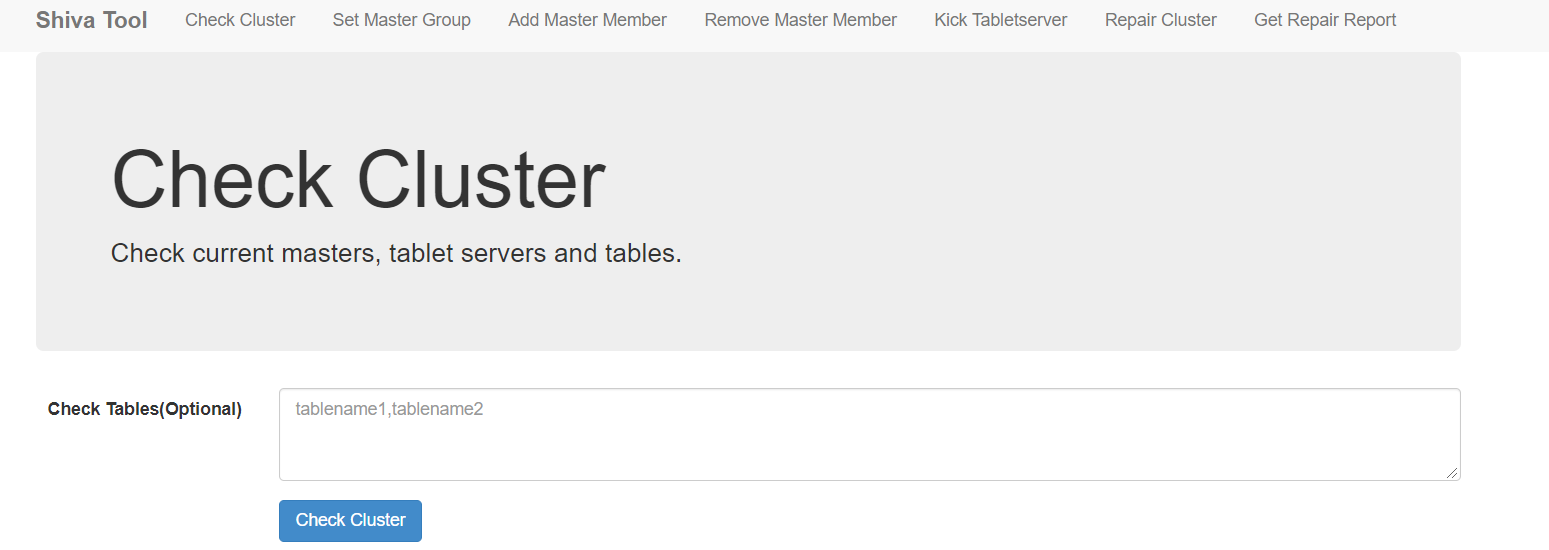

2、登录Shiva 4567的tool界面检查

http://{节点IP或者hostname}:4567/tool

3、点击Check Cluster检查Shiva集群状态

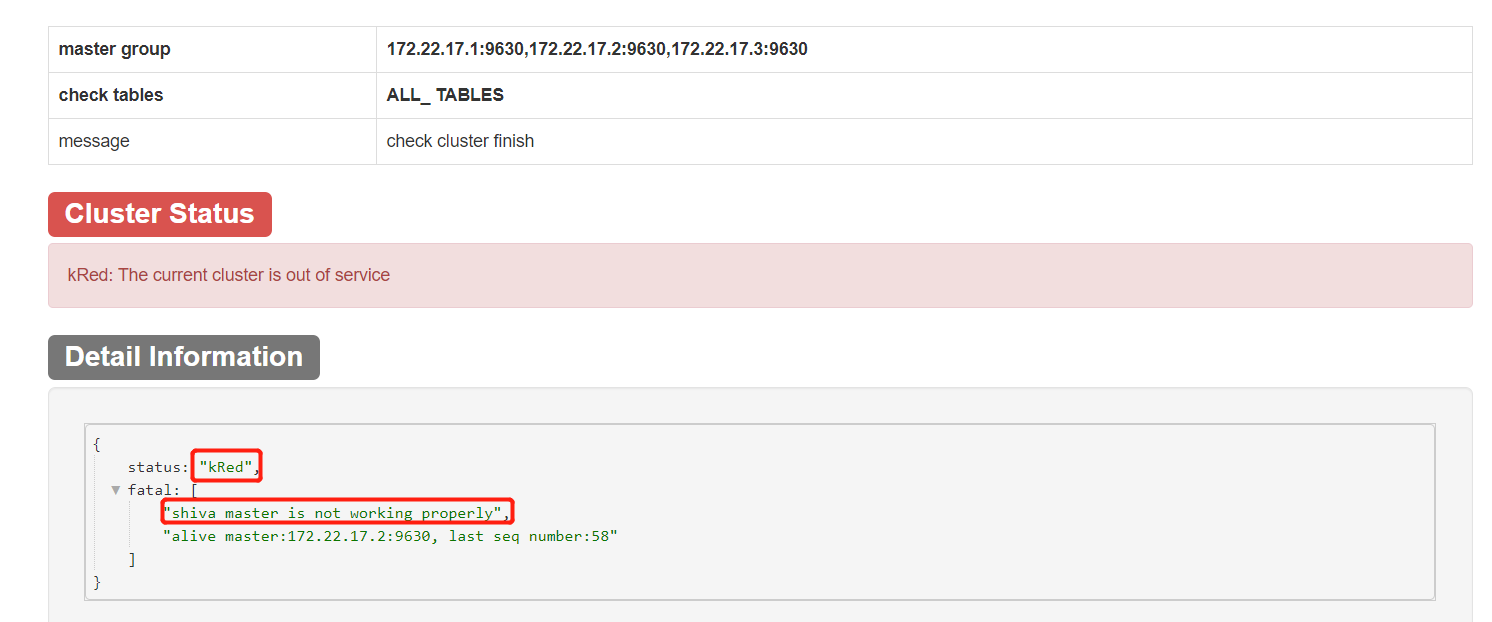

此时可以看到status为:kRed,具体的信息为:shiva master is not working properly,此时需要手动修复。需要用到的信息有:

alive master为172.22.17.2:9630, last seq number为58。

对检查结果的解释:

如结果文件显示 status: kGreen ,表示当前集群状态一切正常。

如结果文件显示 status: kYellow ,表示当前集群服务正常,但存在异常情况,异常情况由 warning 项描述。注意,此时并不需要手工修复集群。

如结果文件显示 status: kRed ,表示当前集群服务/部分服务已经异常,异常情况由 fatal 项描述。此时需要手工修复集群。

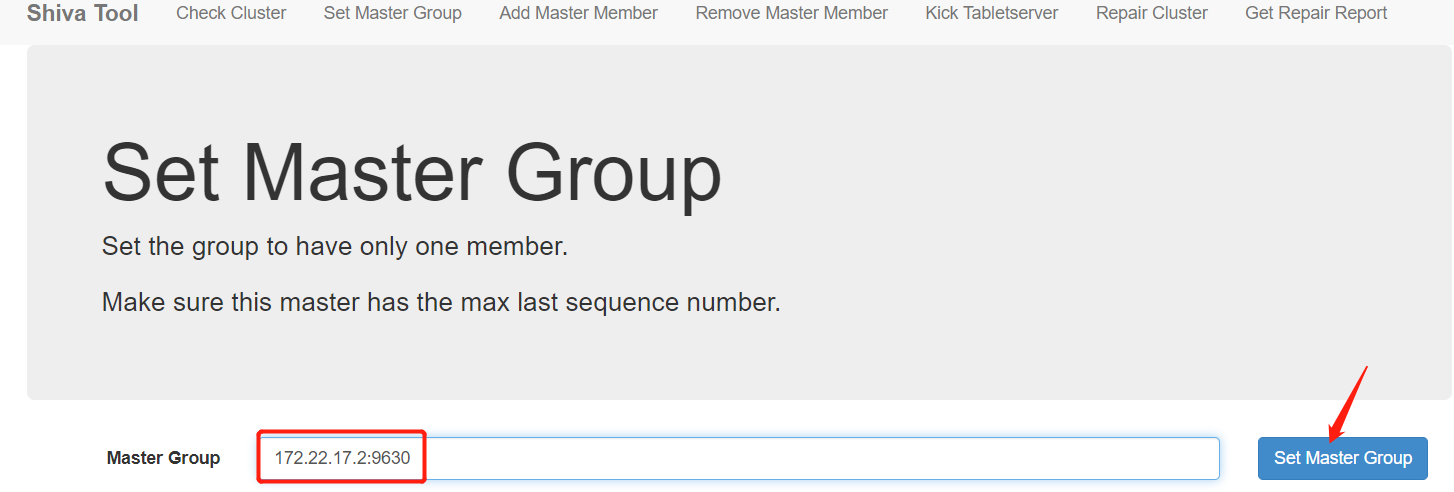

4、在set master member界面完成设置master group

输入栏中填入指定master group即可,此处为上面得到的alive master,即为172.22.17.2:9630

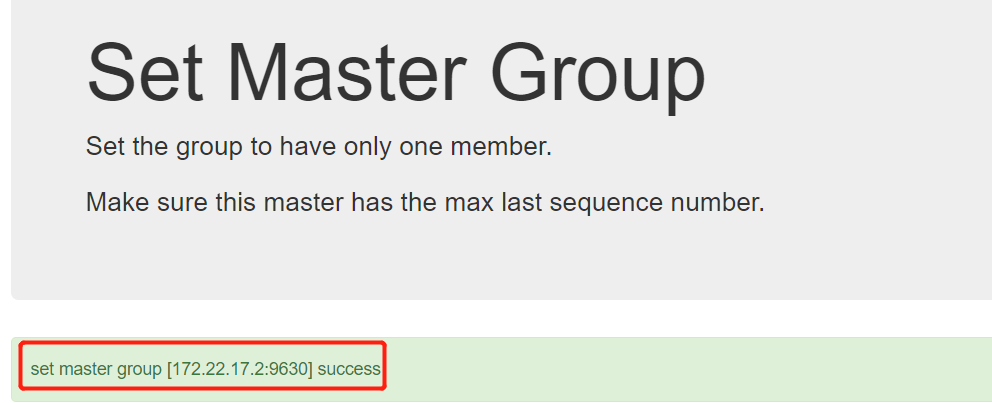

设置完成会有success的提示:

5、将其余的Shiva Master(如果存在)停掉,清除master的 data_path ,并重新启动,作为新的master

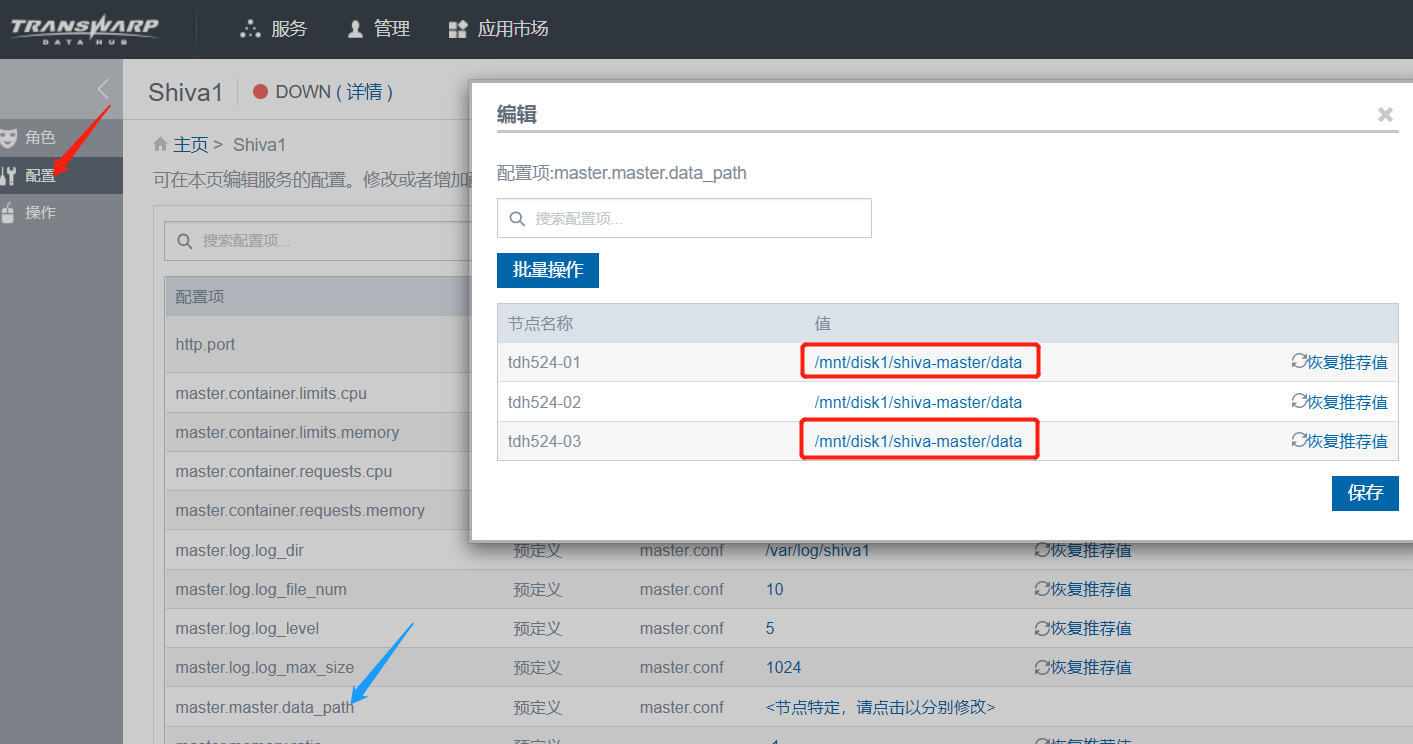

data_path可以从下列位置获取:

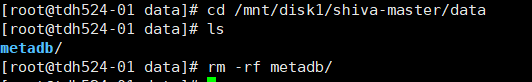

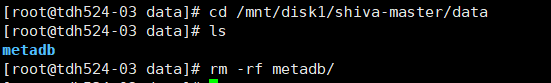

登录到1和3节点上,删除对应的数据目录:

[root@tdh524-03 data]# cd /mnt/disk1/shiva-master/data

[root@tdh524-03 data]# ls

metadb

[root@tdh524-03 data]# rm -rf metadb/

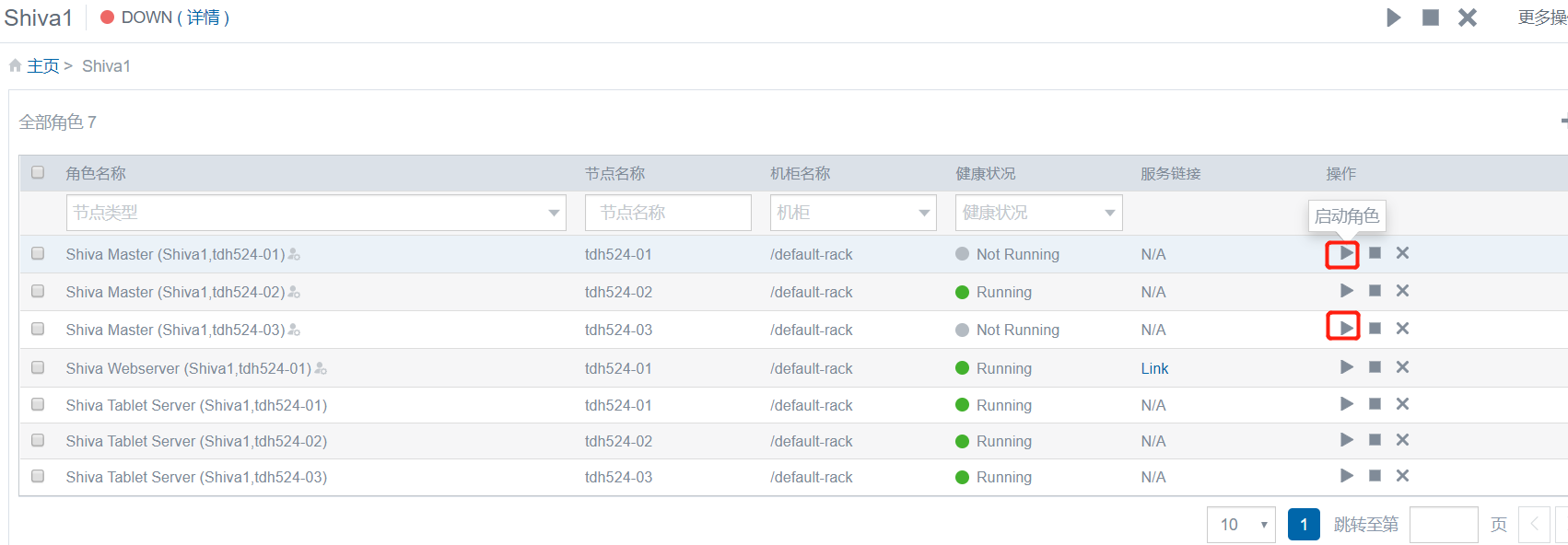

重新启动1、3节点的Shiva Matser:

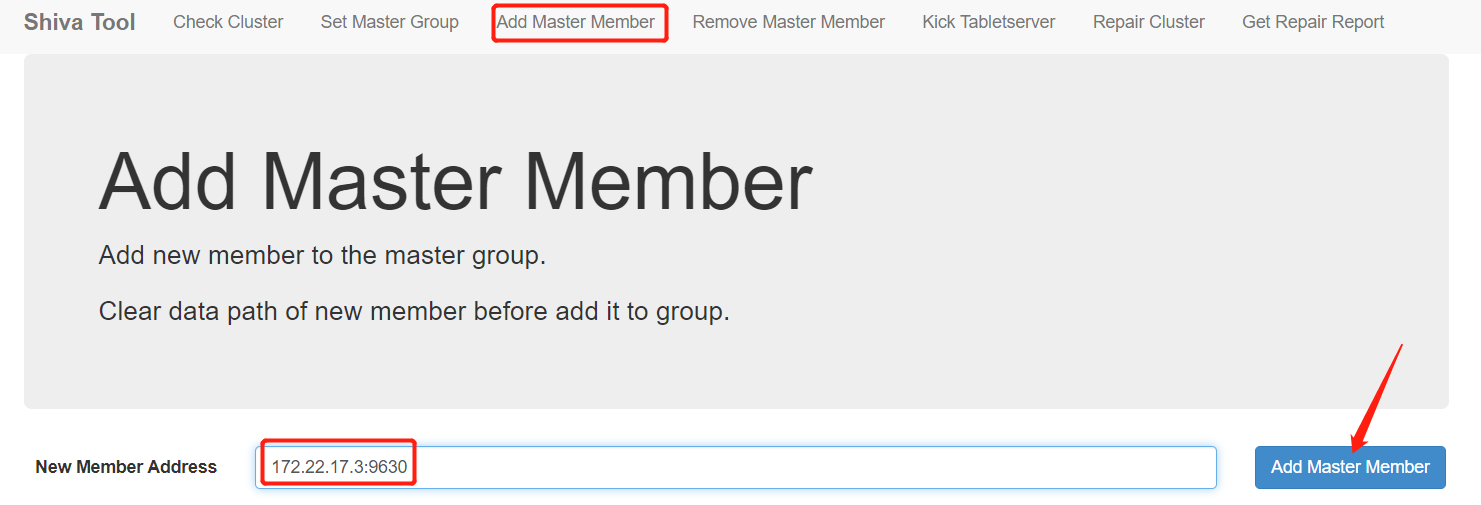

6、通过add member界面可以将新的master加入master group。输入栏中填入新加master即可

此处以3节点为例:

添加成功:

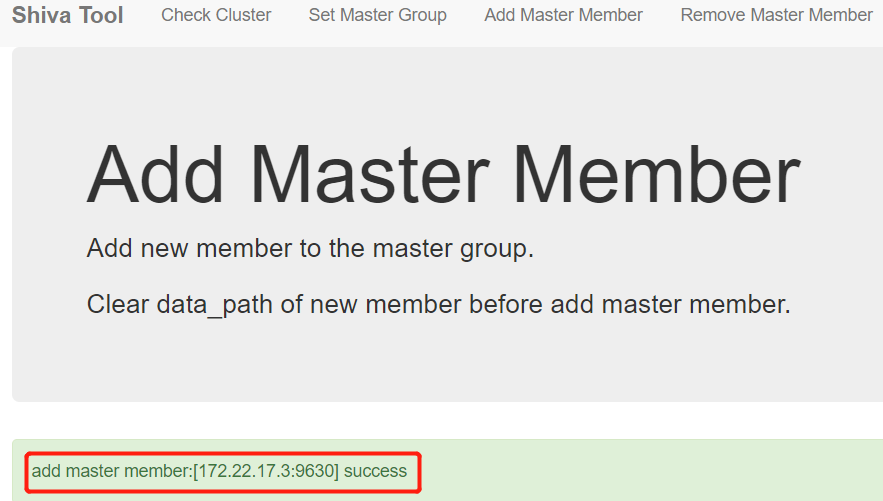

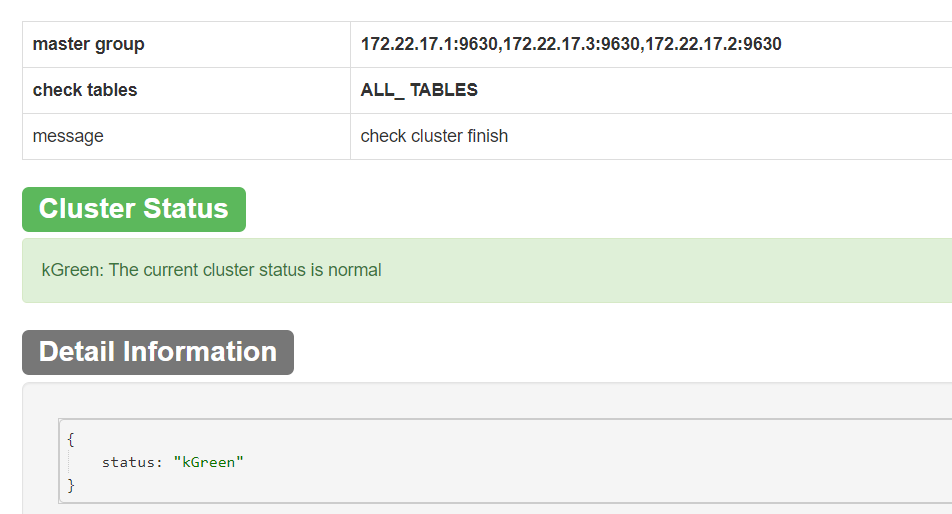

7、再次检查集群状态,点击Check Cluster

此时应该不再出现 shiva master is not working properly 关键字;如集群状态为 kGreen 或 kYellow ,集群修复完成:

FAQ

1、如果出现web ui无法访问的情况,可以检查下webserver的状态,如果webserver启动成功,pod日志没有报错信息,可以检查是否集群对外开放了4567端口的访问权限

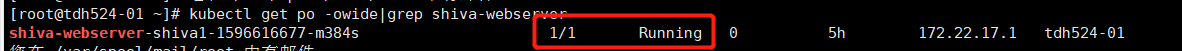

检查webserver的pod状态:

kubectl get po -owide|grep shiva-webserver

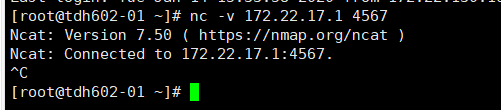

检查当前机器是否可以访问集群内webserver节点的4567端口:

[root@tdh602-01 ~]# nc -v 172.22.17.1 4567

Ncat: Version 7.50 ( https://nmap.org/ncat )

Ncat: Connected to 172.22.17.1:4567.

2、如果4567的tool页面无法访问,可以参考另外一篇KB使用可执行文件在命令行下进行修复:

如何在shell上进行Shiva master group修复

3、如果有组件依赖于Shiva,那么做完修复操作需要配置对应的组件服务,并且重启

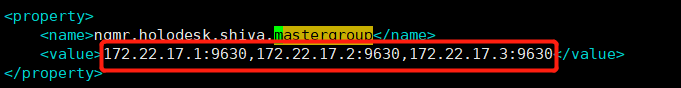

例如使用了基于Shiva的holodesk表,那么需要在修复完成后,对inceptor进行配置服务并且重启方能生效,重启完后可以检查下inceptor server节点的/etc/inceptorx/conf/hive-site.xml中mastergroup信息是否正确: